c't 16/98, S. 150

Dr. Jürgen Rink

Quäntchen für Quäntchen

Fortschritte in der Quanteninformationsverarbeitung

Massive Parallelrechner, absolut sichere Kodiersysteme und neue Kommunikationsformen: In der Welt der Quantenbits wird das bislang Undenkbare zur Realität. Das bis vor kurzem noch exotische Forschungsgebiet etabliert sich mit neuen Konzepten und überraschenden Ergebnissen.

Moderne Computer kommen ohne Quantentheorie nicht aus, denn nur damit lassen sich kleine Halbleiterstrukturen beschreiben. Allerdings erfolgt die Verarbeitung von Information nach wie vor auf klassischem Weg, bei dem Bit für Bit verschoben wird und jedes Bit entweder gleich Null oder gleich Eins ist - seit Babbages Maschinen und den Röhrenrechnern hat sich konzeptionell wenig getan.

Welch kühne Träume jedoch in greifbare Nähe rücken, wenn die Informationstheorie um die Quantentheorie erweitert wird, zeigen Wissenschaftler seit einigen Jahren mit wachsendem Erfolg. Sie bescheren der Informationsverarbeitung völlig neue Rechenmaschinen und Algorithmenstrukturen.

Die ersten rudimentären Quantencomputer und Quantenkommunikation stellten wir letztes Jahr ausführlich vor [1]. Seitdem hat sich in dem lebendigen Forschungsfeld so viel ereignet, daß ein Update notwendig wird: Die Höhepunkte der letzten Monate sind Quantencomputer aus Kernspins in Flüssigkeiten, die erste einfache Suchalgorithmen verarbeiten, und die Teleportation, dem mikroskopischen Pendant des aus Star Trek bekannten Beamens.

Zu neuen Ufern

Der Physiker Richard Feynman entwickelte als erster die Idee vom Computer, der mit Quanteneffekten Information verarbeitet. Was 1982 zunächst als theoretisches Anschauungsmodell ohne konkrete Anwendung gedacht war, entwickelte sich zum handfesten Forschungsgebiet, nachdem spezielle Algorithmen bewiesen, daß der Quantenrechner bei manchen Anwendungen wie Faktorisierung oder Elementsuche den klassischen Computern überlegen ist.

Die Quantentheorie ist die erfolgreichste, aber auch in ihrer Deutung umstrittenste physikalische Theorie. Sie erklärt den Aufbau von Materie und Atom, beschreibt chemische Verbindungen und Radioaktivität. Auch heute noch weigern sich einige Wissenschaftler, die Quantenmechanik als vollständige Theorie zu akzeptieren. Radioaktive Atome, die zerfallen, wann sie wollen, und Elektronen, die sich in mehreren Zuständen gleichzeitig befinden, widersprechen dem gesunden Menschenverstand.

Diese Superposition aus mehreren Zuständen, die ein Quantensystem gleichzeitig annehmen kann, nutzen Quantenrechner aus. Ein Beispiel: Ein 8-Bit-Register eines klassischen Computers hat stets einen bestimmten Zustand, der eine Zahl zwischen 0 und 255 darstellt. Ein Quantencomputer dagegen produziert zuerst eine Superposition von allen 256 Zuständen des Registers gleichzeitig. Während ein klassisches Bit eines von zwei Zuständen einnimmt, kann das Quantenbit, auch Qubit genannt, in beiden gleichzeitig sein. Jede Operation auf die Qubits wirkt auf alle Zustände gleichzeitig und beschert dem Benutzer damit einen massiven Parallelrechner. Dadurch erzielt der Quantencomputer seine Geschwindigkeit, die klassische Rechner nicht erreichen können.

Einen seltsameren Parallelcomputer hat es noch nicht gegeben: Bis dato war jede Information bis zum letzten Bit mit Materie in einem bestimmten Zustand verknüpft. Für 2N Quantenzustände genügen jedoch lediglich N Qubits, die meist aus N Teilchen wie Atomen oder Atomkernen erzeugt werden. Den vielen Quantenzuständen haftet etwas Geisterhaftes an: Man sieht sie nicht, dennoch sind sie vorhanden.

Brutale Messung

Doch die Quantentheorie macht es einem schwer, an die Ergebnisse der Parallelrechner zu kommen. Zwar enthält der Quantencomputer nach abgelaufenem Algorithmus alle Lösungen, da er alle möglichen Zustände als Superposition gespeichert hat, doch am Ende steht immer die Messung, denn schließlich will man das Ergebnis wissen.

Leider zerstört jede Messung komplett und unwiderruflich die Superposition. Damit bleibt vom Parallelrechner genau ein einziger Zustand übrig, das Ergebnis der anderen ist verloren. Welcher Zustand das ist, legt dessen sogenannte Wahrscheinlichkeitsamplitude fest. Je größer diese ist, desto wahrscheinlicher ist es, daß bei der Messung dieser Zustand eingenommen wird.

Zerplatzt der Traum vom massiven Parallelrechner wie eine Seifenblase? Wem nützen N Qubits, wenn sie sich am Ende doch wieder nur als N Bits verhalten und man an das Ergebnis der anderen 2N-1 Zustände nicht herankommt?

Zu kurz gedacht, schmunzelt der Quanteninformatiker, denn diese Denkweise basiert auf dem klassischen Konzept der Informationstheorie, das viel zu eng gefaßt ist, um mit dem Werkzeug Quantencomputer umgehen zu können. Erst ein Quantenalgorithmus, der speziell auf das Verhalten der Superposition abgestimmt ist, macht einen Quantenrechner sinnvoll. Bilden ein paar Qubits eine Superposition von Zuständen, dann sind sie nicht mehr unabhängig voneinander. Sie beeinflussen sich gegenseitig und verändern die Wahrscheinlichkeitsamplituden ihrer Zustände. Wie Wasserwellen, deren Amplituden sich durch Interferenz verstärken oder auslöschen, können Operatoren Wahrscheinlichkeitsamplituden der Qubit-Zustände ändern.

Ein Quantenalgorithmus muß diese Operatoren so einsetzen, daß der Zustand, der zum Beispiel das Ergebnis eines Suchalgorithmus enthält, die Wahrscheinlichkeit eins hat und alle anderen durch Interferenz den Wert null. Eine Messung führt dann zwangsläufig zu diesem Ergebniszustand.

Ein Quantenalgorithmus leistet also viel mehr als ein klassischer Algorithmus, der auf einen Parallelrechner losgelassen wird. Er nutzt aus, daß sich die Zustände, die die Qubits bilden, gegenseitig beeinflussen, indem sich ihre Wahrscheinlichkeitsamplituden verstärken oder aufheben können.

| Software |

Peter Shor von den Bell Labs gelang es als erstem, einen solchen Algorithmus zu finden. Er erfand 1994 ein Verfahren, mit dem sich eine Zahl schneller in ihre Primfaktoren zerlegen läßt als mit jedem klassischen Computer. Das schlug ein, denn wichtige Kryptoverfahren begründen ihre Sicherheit damit, daß es einfach ist, durch Multiplikation große Zahlen zu produzieren, jedoch mit endlicher Rechenkapazität nahezu undenkbar, diese wieder in ihre Faktoren zu zerlegen.

Auch wenn sie die Rechnung ohne den Quantencomputer gemacht haben, können sich die Kryptologen dennoch geraume Zeit in Sicherheit wiegen. Bis ein Rechner mit der notwendigen Anzahl von Qubits auf diesem Planeten private Schlüssel knackt, werden noch viele Jahre vergehen - ein Quantenrechner mit mehr als vier Qubits in diesem Jahrtausend wäre schon eine Sensation. Shors Algorithmus erregte trotzdem zu Recht einiges Aufsehen, denn er zeigte erstens, wie die Quantenparallelität des Rechners zu nutzen ist, zweitens, daß ein solcher Rechner den klassischen Pendants überlegen ist, und vor allem drittens, daß es einen solchen Algorithmus überhaupt gibt. Die Entdeckung führte mit dazu, daß sich Informatiker neuerdings mit Quantentheorie quälen und Physiker die Computerei als innovative Spielwiese für Quantenapparate sehen.

Nadel im Heuhaufen

Der neueste Quantenalgorithmus führte Ende April zu einem für das junge Forschungsgebiet ungewöhnlich großen Presseecho, das noch immer anhält. Letztes Jahr zeigte der Physiker Lov Grover von den Bell Laboratories, wie sich ein Quantencomputer aus einer Menge von N Elementen eines heraussuchen kann. Das ist nichts anderes als das Telefonbuchproblem: Finde eine bestimmte Nummer unter N Telefonnummern. Ein klassischer Computer benötigt dafür im Schnitt N/2 Schritte. Grovers Algorithmus für Quantenrechner erledigt das in nur Sqrt(N)/4-Schritten. Nur wenige Monate später demonstrierten Neil Gershenfeld vom MIT und Isaac Chuang von IBM Almaden, wie das praktisch geht: Sie stellten ein Quantengate aus zwei Qubits her und konnten den Suchalgorithmus für N = 4 implementieren.

Der Coup der Forscher erregte nicht nur öffentliches Aufsehen, weil sie einen der ersten Quantenrechner mit funktionierendem Algorithmus zeigten, sondern brachten damit vor allem ein neues Hardware-Konzept für Quanten-CPUs ins Rampenlicht. Statt wie bisher die Qubits aus einzelnen isolierten Teilchen zu bauen, benutzen sie Atomkerne in gewöhnlichen Flüssigkeiten: Statt eines Qubits befinden sich darin mehr als 1026 Kopien.

Das mag zunächst allem, was man von Quantencomputern weiß, widersprechen, denn jede Wechselwirkung zerstört die Superposition. Doch Atomkerne sind hervorragend isoliert. Sie bestehen aus einem winzigen kompakten Kern und einer äußeren, vergleichsweise riesigen Elektronenhülle, die eine Art natürlichen Schutzschild bietet. Bisherige Quantencomputer blieben lediglich wenige Mikrosekunden intakt, die Kernspin-CPU hält dagegen die Superposition eine Sekunde lang aufrecht.

In Magnetfeldern verhalten sich Atomkerne wie kleine Magnete, die nur bestimmte Einstellungen zum Feld annehmen. Der sogenannte Spin ist die quantenmechanische Größe für diese Einstellungen. Die Forscher erzeugten aus einem Atomkern, der nur zwei Spinwerte annehmen kann, ein Qubit, indem sie mit Radiowellen bestimmter Frequenzen und Dauer den jeweils anderen Zustand anregen.

Die Technik dafür ist wohlbekannt und etabliert, denn die aus der Medizin bekannten Kernspintomographen oder die Kernspinresonanzapparaturen aus der Chemie machen nichts anderes, als mit Radiofrequenzen Kernspins zu detektieren. Die Apparate sind also schon vorhanden und ausgereift.

| Hardware |

Für die zwei Qubits verwendete Gershenfeld ein Kohlenstoffatomkern und ein Wasserstoffatomkern im Chloroform-Molekül. Die Spineinstellungen beider Atomkerne unterscheiden sich in ihrer Energie und können dadurch mit Radiowellen verschiedener Frequenzen getrennt angeregt werden. Zwei Qubits allein bilden jedoch noch kein Quantengatter: Erst die Wechselwirkung zwischen beiden führt zusammen mit Operatoren zu einer Änderung der Wahrscheinlichkeitsamplituden und erlauben die Anwendung von Grovers Suchalgorithmus.

Hier kommt die Natur zu Hilfe, denn das Wasserstoffatom liegt im Chloroform direkt neben dem Kohlenstoffatom. Beide Spins beeinflussen sich durch die sogenannte Spin-Spin-Kopplung, die genau das leistet, was die Forscher von einem Quantengatter aus zwei Qubits erwarten.

Auch die empfindlichste Kernspinresonanzapparatur kann jedoch nicht den Spin eines einzigen Atomkerns messen. Um ein deutliches Signal zu bekommen, verwenden die Forscher deshalb Flüssigkeiten mit einer sehr großen Anzahl von Chloroformmolekülen - ungefähr 1026 kleine Quanten-CPUs tummeln sich in der Suppe.

Der nächste Schritt besteht für die Forscher darin, die Zahl der wechselwirkenden Qubits hochzuschrauben. Die ersten Resultate eines Drei-Qubit-Systems gibt es bereits. Doch die Zahl der Qubits des Molekül-Computers wird zehn nicht übersteigen können, denn die Signalstärke nimmt mit der Zahl der zu messenden Kernspins rapide ab. Abhilfe könnten Laserstrahlen bringen, die mit Laserkühlung der Moleküle die Signale in die Höhe treiben. Das funktioniert ähnlich wie mit Erbsen und Blasrohr einen herannahenden Elefanten zum Stehen zu bringen: Unzählige Photonen streuen mit den herannahenden Atomen und bremsen sie ab.

Ein anderes Problem beim Übergang von zwei zu vielen Qubits ist die Wechselwirkung der Atomkerne. Kerne, die weit voneinander entfernt und nicht nächste Nachbarn sind, wechselwirken nicht stark genug, um Quantengatter zu bilden. Ein Lösungsvorschlag von Seth Lloyd vom MIT sieht ein Redesign der Quantencomputer vor, bei dem die Qubits nur mit den nächsten Nachbarn kommunizieren und der Computer trotzdem seine Rechenkraft behält.

Ionenfalle

Neben dem Rummel um die Kernspin-CPU darf ein anderes Hardware-Konzept nicht vergessen werden: einzelne Ionen in der Ionenfalle. Bei dieser werden die Qubits aus Ionen gebildet, das sind Atome, die einen Mangel oder Überschuß an Elektronen haben. Damit sind sie nicht mehr elektrisch neutral und können mit elektrischen und magnetischen Feldern gefangen werden. Dies geschieht in Ionenfallen, eine Art dreidimensionaler Käfig aus Elektroden, an denen eine Wechselspannung anliegt. Die Apparatur befindet sich im Ultrahochvakuum, um Stöße der Ionen mit Atomen der Umgebungsluft zu reduzieren.

Kurze Laserpulse regen einen elektronischen Zustand im Ion so an, daß sich eine Superposition dieses angeregten Zustandes mit einem anderen bildet. Dieses Qubit ist allerdings wesentlich weniger robust als das Kernspin-Qubit. Deshalb kühlen die Physiker mit Laserstrahlen die Ionen in der Falle noch zusätzlich ab, um die Lebensdauer der Superposition zu erhöhen [1].

Einer Forschungsgruppe am National Institute of Standards and Technology (NIST) gelang es, ein Qubit zu erzeugen. Zur Zeit liefern sich verschiedene Gruppen, die an der Ionenfalle als Quanten-CPU forschen, ein Rennen um logische Gatter in einem Zwei-Qubit-Rechner. Sehr lange wird das aller Voraussicht nach nicht mehr dauern. Die Kernspin-Fraktion ist allerdings bereits auf der Jagd nach einem Drei-Qubit-Rechner.

Außer dem Kernspinrechner und den Ionenfallen existieren noch andere Konzepte für Quantenrechner, die im Moment nicht so sehr im Mittelpunkt des Forschungsinteresses stehen. Miniaturresonatoren, in denen Lichtwellen kontrolliert manipuliert werden, und Quantum Dots, Elektronen in einer Art Atomkäfig in Festkörpern, sind zwei weitere Vorschläge für Quantenrechner.

Aus was auch immer der Quantenrechner besteht, bei allen Modellen zerstört nicht nur die Messung die Superposition und damit den Speicherinhalt die CPU, sondern auch jede Wechselwirkung mit der Umgebung.

Sensibelchen

Zunächst sah es so aus, als ob dagegen kein Kraut gewachsen wäre, außer dem, die Umgebungseinflüsse möglichst zu reduzieren, denn eine Art Fehlerkorrektur für zerstörte Qubits hielt man für ausgeschlossen: Alle bisher bekannten klassischen Korrekturkonzepte basieren darauf, den Fehler zu messen. Das quittiert der Quantencomputer aber erst recht mit einer zerstörten Superposition.

Doch wie schon oft in der kurzen Geschichte der Quanteninformationsverarbeitung dachte man zu klassisch, das heißt zu kurz: Vor zwei Jahren entwarfen Andrew Steane von der Oxford University, Caderbor und Shor Konzepte, wie eine Quantenfehlerkorrektur auszusehen hat. Damit wird Quantenrechnen auch unter dem Einfluß von Dekohärenz möglich.

Das Rezept ist denkbar einfach: Man nehme den Superpositionszustand eines Qubits und verteile ihn auf mehrere andere Qubits. Ursprünglich verwendete Shor dafür neun Qubits; Charles Bennett (IBM) und unabhängig von ihm Raymond Laflamme (Los Alamos) entdeckten einen Fünf-Qubit-Code. Die ursprüngliche Information bleibt intakt, auch wenn eines der fünf Qubits zerstört wird. Vier Operatoren wirken auf die fünf Qubits, um festzustellen, ob und welches Qubit sich verändert hat. Ein sechstes Qubit, das durch die Operatoren mit den anderen fünf in Verbindung steht, verändert seinen Zustand dementsprechend. Eine Messung dieses sechsten Qubits zerstört zwar dessen Superposition, enthüllt aber erstens einen eventuell aufgetretenen Fehler und läßt zweitens die Superposition der fünf anderen intakt.

Nachdem eine Flut von Forschungsarbeiten weitere Fehlerkorrektur-Codes beschreiben, wird die Zukunft schlankeren und spezialisierten Verfahren gehören, die auch die spezielle Hardware in ihren Konzepten berücksichtigen. Nachdem man vor kurzem gelernt hat, wie ein Quantenzustand an einen anderen Ort gebeamt wird, könnten Qubits nach durchlaufenem Algorithmus in Quantenspeichern zwischengelagert werden, die eine sehr lange Kohärenzzeit bieten, um anschließend in eine weitere Quanten-CPU übertragen zu werden.

| Quantenkommunikation |

Bevor die Quantencomputer für Schlagzeilen sorgten, existierten bereits ausgereifte Konzepte für Quantenkryptographie, die sich in den letzten Jahren zur Quantenkommunikation erweiterte. Die Kryptographie ist das am weitesten entwickelte Gebiet der Quanteninformationsverarbeitung. Mit Glasfasern konnte bereits über zehn Kilometer verschlüsselte Information übertragen werden.

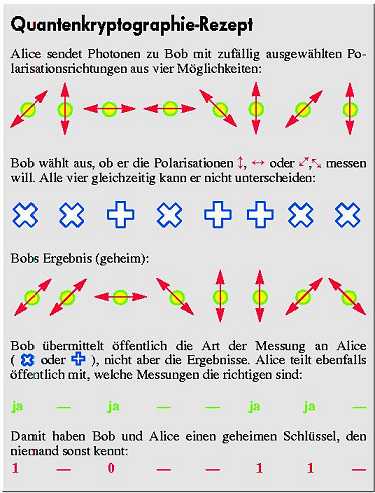

Die Quantenkryptographie nutzt den sonst unerwünschten Effekt, daß jede Messung und jede Störung ein Quantensystem stört. Wenn Bob und Alice einen Geheimschlüssel austauschen, der auf Quantenzuständen beruht, dann verändert jeder Spionageversuch von außen den Schlüssel - was die beiden sofort bemerken.

Schon 1984

entwarfen Charles Bennett und Gilles Brassard ein

Kommunikationsprotokoll. Alice und Bob sind durch einen normalen

öffentlichen Kanal (z. B. Telefon) und einen Quantenkanal

(Glasfaser) verbunden. Mit einem von zwei Polarisatoren, die die

Schwingungsebene des elektrischen Feldes von Licht messen, sendet

Alice Photonen, also Lichtteilchen, die Bob mißt. Bob hat

ebenfalls zwei verschiedene Polarisatoren und teilt Alice über

das Telefon mit, bei welchem Photon er welchen von beiden

genommen hat. Das Ergebnis behält er jedoch für sich. Alice

sagt ihm, welches Meßergebnis er für den Code verwenden soll,

denn nur wenn Alice und Bob den gleichen Polarisator gewählt

haben, ist das Ergebnis sinnvoll. Eine Polarisationsrichtung ist

logisch eins, die andere logisch null. Damit haben beide einen

Code, um ihre Information zu verschlüssseln.

Schon 1984

entwarfen Charles Bennett und Gilles Brassard ein

Kommunikationsprotokoll. Alice und Bob sind durch einen normalen

öffentlichen Kanal (z. B. Telefon) und einen Quantenkanal

(Glasfaser) verbunden. Mit einem von zwei Polarisatoren, die die

Schwingungsebene des elektrischen Feldes von Licht messen, sendet

Alice Photonen, also Lichtteilchen, die Bob mißt. Bob hat

ebenfalls zwei verschiedene Polarisatoren und teilt Alice über

das Telefon mit, bei welchem Photon er welchen von beiden

genommen hat. Das Ergebnis behält er jedoch für sich. Alice

sagt ihm, welches Meßergebnis er für den Code verwenden soll,

denn nur wenn Alice und Bob den gleichen Polarisator gewählt

haben, ist das Ergebnis sinnvoll. Eine Polarisationsrichtung ist

logisch eins, die andere logisch null. Damit haben beide einen

Code, um ihre Information zu verschlüssseln.

Jede Messung eines Spions während der Übertragung des Photons ändert die Polarisationsrichtung von mindestens einem Viertel der Photonen. Das merken Alice und Bob, wenn sie sich einen zufällig ausgewählten Teil ihrer gemessenen Polarisationen öffentlich übermitteln. Stimmen die Ergebnisse nicht überein, dann verwerfen sie den Code.

Scotty, beam me up!

Der jüngste und spektakulärste Wurf der Quantenkommunikation ist der experimentelle Nachweis der Teleportation. Was Star-Trek-Fans schon lange kennen, wurde jetzt auf submikroskopischer Ebene Wirklichkeit. Um ein Objekt an einen anderen Ort zu beamen, muß die vollständige Information von diesem übertragen werden. Dem scheint die Quantentheorie Grenzen entgegenzusetzen: Die Heisenbergsche Unschärferelation verbietet, Größen wie Ort und Impuls oder Energie und Zeit gleichzeitig mit beliebiger Genauigkeit zu messen. Das heißt, alle Eigenschaften eines Systems lassen sich nicht vollständig bestimmen. Der einzige Ausweg ist, das System zu übertragen, ohne ihn zu messen, wie Charles Benett 1993 theoretisch zeigte und Anton Zeilinger von der Universität Innsbruck kürzlich experimentell demonstrierte.

Die Quantenteleportation nutzt dabei das für klassisch gebildete Gemüter am schwersten zu schluckende Ergebnis der Quantentheorie: Zwei Teilchen, deren Zustände eine Superposition bilden, tun das auch noch, wenn sie sich ungestört voneinander entfernen. Eine Messung an einem der Teilchen ändert dann den Zustand des anderen, egal, ob sie Mikrometer oder Kilometer auseinander sind. Diese Fernwirkung oder Nichtlokalität war Gegenstand vieler Kontroversen, bevor in den 70er Jahren Experimente die Quantentheorie auf der ganzen Linie bestätigten.

Die beiden wechselwirkenden Quantenteilchen bilden die Brücke, um den unbekannten Zustand zu übertragen. Zeilinger verwendet für sein Experiment Photonen, deren Polarisationsrichtungen eine Superposition bilden. Die unbekannte Polarisation eines dritten Photons wird gebeamt.

Superpositions-Photon 1 wird mit dem zu übertragenden Photon, dessen Polarisationsrichtung unbekannt ist, quantenmechanisch gekoppelt. Das hat Auswirkungen auf Teilchen 2 am anderen Ort, das genau den unbekannten Polarisationzustand einnimmt. Damit ist die Aufgabe gelöst, die vollständig unbekannte Information ist übertragen.

Die Teleportation wird nicht nur zu neuen Konzepten in der Quantenkommunikaiton führen, sondern auch für die Quantencomputer eine Rolle spielen. Über alle Schranken und Wände und Apparaturen kann man durch Teleportation eine sonst schnellebige Superposition nach durchlaufenem Algorithmus innerhalb der Dekohärenzzeit auf ein weiteres, unter Umständen stabileres System teleportieren.

| Fazit |

Die Fortschritte sind enorm: David Deutsch legte 1985 mit dem Modell der Quanten-Turing-Maschine die theoretische Basis für das damals Undenkbare und erweiterte die bislang der klassischen Physik verhaftete Informationstheorie. Heute stehen bereits die ersten rudimentären Quantencomputer in den Laboratorien, von denen die Kernspin-Qubits zur Zeit die besten Erfolgsaussichten haben. Suchalgorithmen, die bereits in die Praxis umgesetzt wurden, Quantenfehlerkorrektur und neue Kommunikationskonzepte wie Teleportation überraschen selbst Fachleute.

Die Forschung rund um die Qubits hat längst die Exotikerecke verlassen und ist fester Bestandteil der Forschungslandschaft geworden. Der Forschungsarm des Pentagon, DARPA, prescht vor und unterstützt Quanteninformation und Quantencomputer mit insgesamt fünf Millionen Dollar. Europa zieht mit einem EU-Projekt nach, dem Physics of Quantum Information European Research Network. Dem Netzwerk gehören neun Forschungsgruppen an. Vom 24. bis 26. September 1998 treffen sie sich zum Internationalen Workshop über die Physik der Quanteninformation (siehe Kasten).

Doch trotz der Fortschritte sind selbst beteiligte Wissenschaftler skeptisch, ob im nächsten Jahrzehnt ein Quantencomputer gebaut werden kann, der zumindest in einigen Anwendungen den klassischen Supercomputern nicht nur theoretisch überlegen sein wird.

Die kurze, stürmische Geschichte der Quanteninformatik mit ihren überraschenden Wendungen und großen Fortschritten lehrt allerdings, daß Prognosen hier noch weniger gültig sind als in anderen Forschungsgebieten. Der Grover-Algorithmus oder die Quantencomputer auf NMR-Basis sind Siebenmeilenschritte, die keiner vorausgesehen hat. Gershenfield gehört zu den Optimisten: Er prognostiziert in zehn Jahren bereits einen Quantencoprozessor. Wer auch immer recht haben wird, die Quantencomputer bilden ein riesiges Spielfeld für Innovationen. Nicht Evolution kennzeichnet die Quanteninformationsverarbeitung, sondern Revolution, die eingefahrenen Denkweisen ihre Schranken zeigt. (jr)

Literatur

- [1] Jürgen Rink, Alice im Wunderland, Quantenrechner auf dem Sprung zur Realität?, c't 3/97, S. 110

Quantum Computation im Web

QUIC-Kollaboration: QUIC (Quantum Information and Computation) besteht aus fünf Forschungsgruppen von Caltech, MIT und der Universität von Kalifornien. Sie beschäftigen sich mit Quantengattern, Fehlerkorrektur und Simulation von Quantencomputern.

Quantum Physics e-Prints: Das Angebot enthält eine Datenbank inklusive Suchoption von wisssenschaftlichen Veröffentlichungen über Quantenphysik seit Dezember 1994. Die Artikel über Quanteninformation findet man hier - abgesehen von den populärwissenschaftlichen Veröffentlichungen.

Bibliographie über Quantenkryptographie: Gilles Brassard von der Universität Montreal stellte eine gut gegliederte und ausführliche Bibliographie zum Thema Quantenkryptographie zusammen. Leider wurde sie seit Juli 1996 nicht mehr weitergepflegt.

The Stanford-Berkeley-MIT-IBM Quantum Computation Research Project: Forschungsprojekt mit Wissenschaftlern aus Berkeley, Stanford University, MIT und IBM. Die Site enthält Informationen zu NMR-Quantencomputern, Quantenalgorithmen und ein hilfreiches Archiv mit Artikeln zu Quantencomputern und zur Theorie der Quanteninformation.

Institut für Experimentalphysik der Universität Innsbruck: Rainer Blatts Forschungsgruppe in Innsbruck baut Quantencomputer mit Ionen, die in einer Ionenfalle gespeichert sind.

Institut für Experimentalphysik der Universität Innsbruck: Infos der Forschungsgruppe um Anton Zeilinger zu Quantenteleportation. Link-Sammlung zu Forschungsgruppen, die sich mit Quanteninformation beschäftigen.

Imperial College in London: Die Quantencomputer-Site des Imperial College in London enthält eine kurze Einführung und eine interessante Link-Sammlung zum Thema.

The Physics of Quantum Information European Research Network: Forschungsprogramm der europäischen Kommission, das die europäischen Aktivitäten rund um Quantencomputer und Quantenkommunikation fördert. Insgesamt neun Forschungsgruppen beteiligen sich am Netzwerk. Die Site enthält Informationen zum 'International Workshop on the Physics of Quantum Information', der am 24. bis 26. September 1998 in Helsinki stattfindet.

Centre for Quantum Computation: An der Universität Oxford gibt es ein Centre for Quantum Computation. Das Web-Angebot enthält sehr gute Einführungen zu Quantencomputer, Quantenkryptographie und Quantenkommunikation.